"הסרנו מכשול גדול בדרך לבינה מלאכותית מהירה וזולה יותר"

מודלי שפה הם בזבזניים בין היתר בשל חוסר התאימות בין השפות הדיגיטליות הייחודיות שלהם. אלגוריתם של אינטל ומכון ויצמן גבר על הבעיה וכבר שולב בפלטפורמת הקוד הפתוח הפופולרית Hugging Face

החוקרים. מימין לשמאל: משה וואסרבלאט, אורן פרג,דניאל קורט, ומשה ברכנסקי

חוקרים ממכון ויצמן ומאינטל הציגו מחקר שלדבריהם מסיר "מכשול גדול בדרך לבינה מלאכותית מהירה וזולה יותר". החוקרים חשפו את המחקר בכנס הבינלאומי ללמידת מכונה (ICML), והיו חלק מאחוז אחד של מצטיינים, שהציגו אותו בעל פה, מתוך 15,000 עבודות שהוגשו לכנס.

על פי ההודעה המשותפת של שני הארגונים, המחקר מציע פתרון אלגנטי לבעיה ותיקה ב-LLM, שכבר אומץ על ידי קהילת הקוד הפתוח וזמין לשימוש נרחב.

הבזבוז של מודלי שפה גדולים שעליהם מבוססת למשל בינה מלאכותית יוצרת, הם איטיים וזוללי משאבים. כמה משאבים? לפי דיווח מחודש אפריל, בחמש השנים הקרובות הבינה המלאכותית תעקוף את יפן בצריכת חשמל.

כל עדכוני ה-IT, תשתית וטכנולוגיה בערוץ הטלגרם של ITtime

כמה חישובים רק בשביל להגיד "פריז עיר האורות"

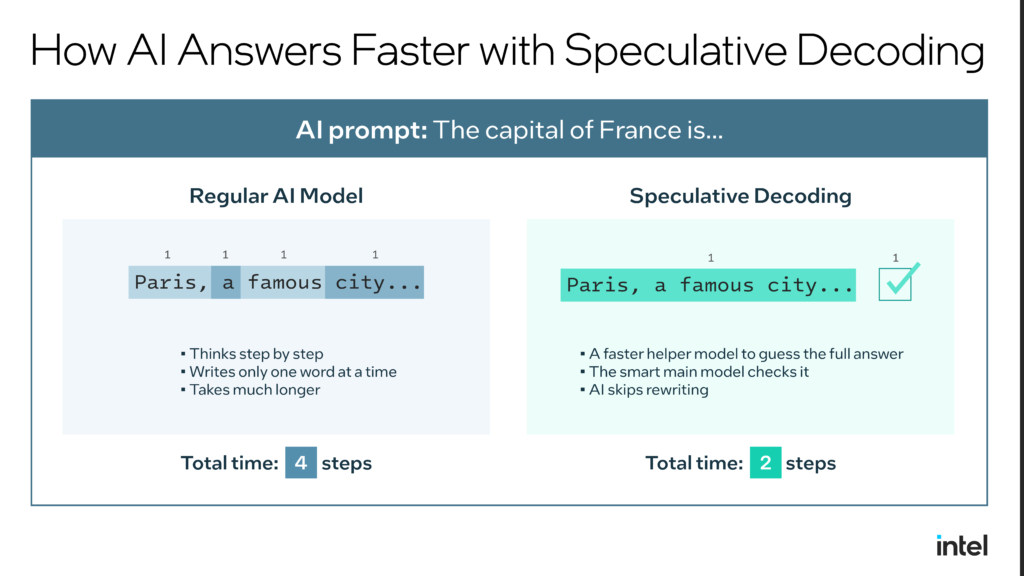

החוקרים מסבירים כי כיום התעשייה משתמשת בשיטה שנקראת "פענוח ספקולטיבי" (Speculative Decoding), ובה יש מודל עוזר קטן שמנחש במהירות את המשך הטקסט, והמודל הגדול והחזק רק צריך לאמת את הניחוש במקום לייצר את הכל מאפס.

בדוגמה שהחוקרים נותנים, מבקשים ממודל שפה שישלים את המשפט "בירתה של צרפת היא". למרות שזה מידע שנראה שאפשר לשלוף בקלות מוויקיפדיה או ממאגרי מידע אחרים, מודל שפה ללא פענוח ספקולטיבי חושב ומייצר את המילה "פריז", מה דורש כוח חישוב רב.

לאחר מכן המודל קורא את המשפט החדש – "בירתה של צרפת היא פריז" וחושב שוב כדי לייצר את המילה הבאה: "עיר". ובשלב השלישי הוא שוב קורא את הכל בשביל להשלים את המילה "אורות".

כלומר, כדי לייצר שלוש מילים, המודל הגדול נדרש לשלושה סיבובי חשיבה נפרדים ויקרים.

כשהמודלים לא מדברים אותה שפה

בעזרת פענוח ספקולטיבי בשלב הראשון המודל הקטן יותר שמשמש כעוזר, מנחש ויוצר מיד טיוטה של שלוש המילים: פריז, עיר, והאורות. בשלב השני המודל הגדול בודק את הטיוטה בבת אחת (במקום בשלושה סבבים) ומאמת אותו.

כדי לייצר את אותן שלוש מילים, מסבירים החוקרים, המודל הגדול נדרש רק ל"סיבוב חשיבה" אחד ויעיל כדי לאשר את הטיוטה כולה. החיסרון בשיטה הזאת הוא שהיא עובדת רק אם שני המודלים מדברים באותה שפה דיגיטלית שעל בסיסה נבנו – מילון ייחודי של צורות וסימנים (tokens). כל חברה שמפתחת מודלי שפה גדולים, יוצרת לעצמה מילון ייחודי כזה ואין תאימות ביניהם.

כך, מסבירים החוקרים, מפתחים לא יכלו לבחור את המודל הקטן והמהיר ביותר בשוק, אלא רק את זה שמתאים למודל הגדול שלהם, מה שהפך את כל התהליך למסורבל, יקר, ולעיתים קרובות פשוט בלתי אפשרי.

לשלב בין מודלים שונים

המחקר החדש שובר את הסגרגציה הזאת ומאפשר למפתחים לשלב כל מודל קטן עם כל מודל גדול, גם אם הם פותחו על ידי חברות שונות, מבוססים על ארכיטקטורות שונות ומשתמשים באוצר מילים שונה לחלוטין.

"המחקר שלנו מראה כיצד ניתן להפוך את ההאצה הספקולטיבית לכלי אוניברסלי, אומר אורן פרג, חוקר בכיר במעבדות אינטל ואחד ממחברי המאמר. "הסרנו מכשול גדול בדרך לבינה מלאכותית מהירה וזולה יותר", מוסיף נדב תימור, דוקטורנט בקבוצת המחקר של פרופ' דוד הראל במכון ויצמן למדע והמחבר הראשון של המאמר, "האלגוריתמים שפיתחנו מאפשרים שיטות האצה שעד כה היו זמינות רק לארגונים שאימנו לעצמם מודלים קטנים של בינה מלאכותית".

האלגוריתמים שפותחו כבר שולבו בפלטפורמת הקוד הפתוח הפופולרית Hugging Face ומאפשרים לכל מפתח להשתמש בטכנולוגיה כמוצר מוכן, להאיץ מודלים שונים ללא התאמה מורכבת, ולהנגיש את טכנולוגיית הבינה המלאכותית המתקדמת לקהל רחב יותר.