מחוץ לחוק: שימוש אחראי ב-AI הוא כבר לא רק בעיה של עולם הטק

הבינה המלאכותית כבר קובעת מי ייעצר, מי יתקבל לעבודה ומי יקבל טיפול רפואי - והכול בלי כללים, בלי שקיפות ובלי אחריות

תמונה: dreamstime

הבינה המלאכותית כבר פרצה את גבולות הטק וכיום היא משמשת עובדים כמעט בכל תחום – עורכי דין, שוטרים, הוראה, אפילו שרים בממשלה. זה יפה לראות איך כל כך הרבה מגזרים מאמצים טכנולוגיה חדשה, אך ככל שהיא תופסת חלק נכבד ביותר תחומים בחיינו, שאלת הפיקוח והאפקטיביות שלו הולכת ונהיית דחופה יותר – בכל תחום משמעותי בחיינו יש חקיקה, ואילו נושא הבינה המלאכותית מזדחל מאחור על אף הסכנות ששימוש לא מבוקר בה עלול ליצור; סכנות שכבר ראינו עד כמה עמוקה יכולה להיות מידת ההשפעה שלהן על חיינו.

בחודש שעבר שופט בית משפט השלום רתח מזעם כשעורך דין מטעם המשטרה הגיש מסמך שנכתב על ידי בינה מלאכותית שהמציאה חוקים שלא קיימים, וכבר לפני שנתיים עורך דין אחר כשל בשימוש ב-ChaGPT בעת הגשת תביעה, לאחר שהצ'אט המציא תיקי עבר שמעולם לא נידונו.

רק בשבוע שעבר רוברט קנדי ג'וניור, מזכיר הבריאות האמריקאי, הגיש דוח תחת הכותרת "Make America Healthy Again", שמטרתו להבין מה עומד מאחורי הירידה בתוחלת החיים בארצות הברית ובעל יכולת השפעה על החיים של כל אזרח אמריקאי. תחקירים הראו כי הדוח, באורך של 72 עמודים, נכתב כנראה על ידי ChatGPT ומכיל לא מעט דקויות כושלות, או יותר נכון – המצאות.

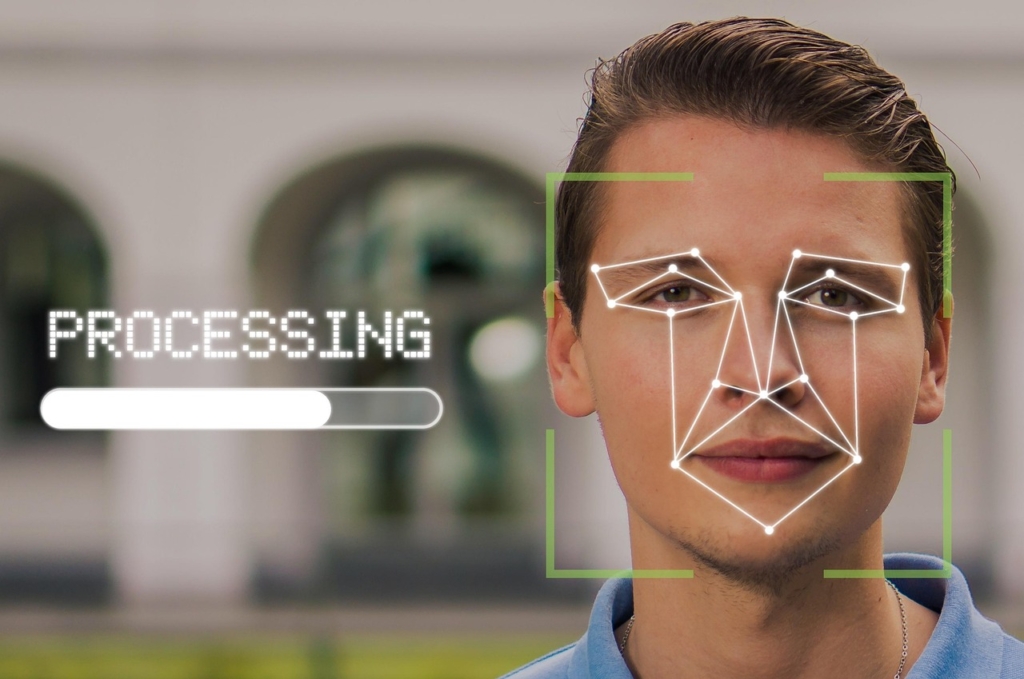

כבר לפני כחמש שנים כולנו הזדעזענו מהמקרה של רוברט ג'וליאן-בורטש, תושב דטרויט, שנעצר על ידי המשטרה רק בגלל תוכנת זיהוי פנים שטעתה בזיהוי. הוא בילה שעות במעצר על פשע שלא ביצע ואף נדרש להיאבק כדי להוכיח את חפותו. אבל זו לא טעות נקודתית: דוח של MIT מ-2018, שנערך על ידי ג'וי בולמוויני וטימניט גברו, חשף פערים מדאיגים בדיוק של מערכות ניתוח פנים מסחריות: המחקר מצא כי שיעור הטעויות בזיהוי מגדר של נשים כהות עור הגיע עד ל-34.7%, לעומת שיעור טעויות של פחות מ-1% בזיהוי גברים בהירי עור, שיעור המצביע על הטייה באימון המודל. למרות ממצאים אלו, רשויות אכיפת החוק ממשיכות להסתמך על הטכנולוגיות הללו.

תמונה: pixabay

אין הסברים, אין דרך לערער

אלה לא מקרים בודדים וזה ממש לא הסוף – אלגוריתמים של מערכות משפטיות בארה"ב כמו מערכת COMPAS משמשים להערכת "מסוכנות" של נאשמים, ומשפיעים על פסיקות שיפוטיות. אלא שהתברר שהם מעניקים ציוני סיכון חמורים יותר לאנשים ממוצא אפרו-אמריקאי על אף שאין להם עבר פלילי בהשוואה ללבנים – עם עבר עשיר. וכל זה "כי ככה התוצר של האלגוריתם".

מחקר אחר מהשנה האחרונה הוכיח כי הבינה המלאכותית גם מפלה נשים בראיונות עבודה. אנחנו כבר בעולם שבו האלגוריתם קובע מי יתקבל לעבודה. האם בקרוב הוא גם יקבע עם מי נתחתן? זה עדיין לא פרק של "מראה שחורה" אבל זה יכול להיות, כי כרגע אין בישראל תקנות שמסדירות את הנושא.

וזה אולי הדבר המתסכל ביותר: אנשים נפגעים, לעיתים נעצרים או מופלים בלי אפשרות להבין מדוע, בלי דרך לערער ובלי אחריות וכתובת משפטית ברורות. האלגוריתם הוא עצמו ה"קופסה השחורה", ללא יכולת להסביר את תוצריו, והחברה שפיתחה אותו – מתנערת מאחריות, ולא חייבת לתת דין, כי אין אחד כזה. רק לאחרונה החלו להתפתח מודלי בינה מלאכותית המנסים להציג "הסברתיות" ("Explainability") באופן הפעולה שלהם.

בכל חברה דמוקרטית אחד הערכים החשובים ביותר הוא עיקרון השקיפות, האחריות והאפשרות להגשת סעד. בינה מלאכותית שאינה מאוסדרת, אפילו אולי מפוקחת, שוברת את הכללים. כשהאדם מוחלף במערכת אוטומטית שלא מפעילה הקשר, מוסר או חמלה – נוצר ואקום מוסרי, והאבסורד הוא שבקצב העיכוב שלנו באסדרה למול מהירות הפיתוח בתחום – אנחנו מאפשרים לזה לקרות.

החוק מתייחס ל-AI כעוד תוכנה

הטכנולוגיה נוחה לנו ואף אחד לא מחכה למחוקק. גופי ממשל, בנקים, מעסיקים ובתי משפט משתמשים ב-AI עוד לפני שהוגדרו כללים, זכויות או אחריות. החוק התקף כיום נאלץ להתייחס לבינה מלאכותית כאילו היא עוד תוכנה ולא באופן ייחודי, ככלי החובק סיכון אדיר, ללא יכולת להבין את התרחשותו והטיותיו, וכל זה בלחיצת כפתור.

אף אחד לא מחכה למחוקק – גופי ממשל, בנקים, מעסיקים ובתי משפט משתמשים ב-AI עוד לפני שהוגדרו כללים, זכויות או אחריות. החוק התקף כיום נאלץ להתייחס לבינה מלאכותית כאילו היא עוד תוכנה , ללא יכולת להבין התרחשות והטיות

באיחוד האירופי כבר נחקק חוק ה-AI הראשון מסוגו בעולם, שמגדיר רמות סיכון וכולל דרישות והגבלות משתנות לפי רמות הסיכון. בישראל ובארה"ב התפתחות הרגולציה עוד נמצאת בחיתולים ותוצאת ה"הזדחלות הרגולטורית" קטלנית – אנו מותירים שדה פתוח להפרות זכויות אדם, להפליה פסולה שאינה מוסברת ולטעויות קריטיות המהוות נזק נרחב , בלי שום תמרורים מראש, נתיבי פעולה, ניטור התנהלות ובלי בלמי בטיחות.

וכמובן שזה לא יעצור כאן אלא יתרחב. מי יכולה להבטיח שבקרוב הבינה המלאכותית לא תנהל את תיעדוף התורים לרופאים? תחליט מי יזכה לקבל תרופות ראשון או מי זו שתקודם בעבודה? ללא רגולציה מכוונת מראש, מנטרת, אוכפת, מרתיעה, אבל עדיין – מאפשרת, אנחנו פשוט מכניסים את עצמנו לעולם בו טעויות קורות בשקט, בחסות טכנולוגיה שמעטים באמת מבינים – עד שזה מגיע גם אלינו.

רגולציה חייבת להתייחס לשאלה האחריות – מי נושא באחריות כאשר מערכת בינה מלאכותית טועה? אסדרה ראויה נדרשת לקבוע אחריות משפטית, כללים לשימוש בטכנולוגיה בתחומים רגישים כמו רפואה, תחבורה, אכיפת חוק, פיננסים, תעסוקה וחינוך, וגם לעסוק בשימוש במודלים גנרטיביים (כמו צ’אטבוטים או יוצרי תמונות ותוכן) שאיתם ניתן להפיץ מידע שגוי או לשמש ליצירת תעמולה ופייק ניוז. רגולציה יכולה לחייב סימון תכנים שנוצרו על ידי AI, להגביל שימושים פוליטיים או מסוכנים אחרים, ולהגביר שקיפות.

במילים אחרות, השימוש בבינה מלאכותית מתרחב אקספוננציאלית – והרגולציה לא רק שלא מדביקה אותה, היא אפילו מזדחלת מאחור. כבר לא מדובר במצגת להנהלה, מאמר לתזה או אפילו החלטות עסקיות – חוסר האסדרה של אופני הפיתוח, האימון והשימוש בבינה מלאכותית וההשלכות על שימוש לא נכון או ראוי – ישפיע עמוקות על חיינו כאזרחים במדינה.

הכותבת היא עו"ד, רו"ח ויועצת רגולציית בינה מלאכותית וקריפטו לגופים, ארגונים ופרטיים, והיא מנכ"ל JAGuar AI Regulation