טראמפ רוצה רגולציה רזה ל-AI. מי שיישא באחריות הם הארגונים

הצו הנשיאותי החדש של טראמפ מצהיר מלחמה על "Woke AI" ומסיר חסמים מהמגזר הטכנולוגי, אבל מתעלם מהשאלה הקריטית: מה קורה כשה-AI שוגה, מפלה או מפר זכויות? ללא רגולציה, האחריות הולכת ליפול על כתפי הארגונים

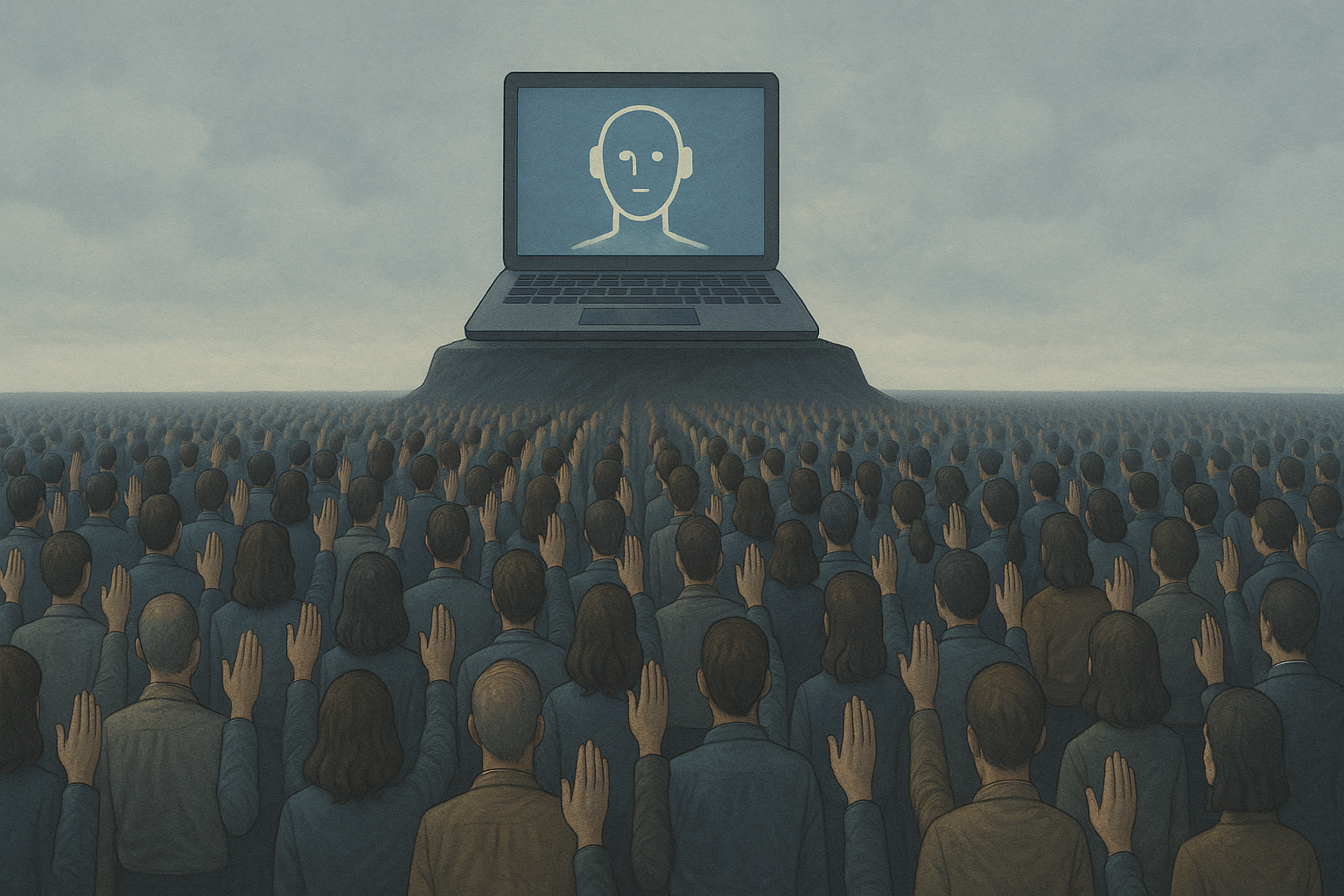

תמונה: נוצרה באמצעות ChatGPT

נשיא ארצות הברית דונלד טראמפ חתם הלילה על צו נשיאותי רחב היקף שמטרתו לעצב מחדש את הדרך בה חברות וארגונים משתמשים, מנצלים ומאמנים את הבינה המלאכותית. שתי המטרות המרכזיות של הצו החדש הן להיאבק במה שהבית הלבן מגדיר בתור "Woke AI", על מנת להבטיח שהמערכות בהן משתמש הממשל יהיו נטולות הטיה אידיאולוגית, ולהסיר רגולציה וחסמים בירוקרטיים כדי להאיץ את בניית התשתיות, כמו דאטה סנטרים, ולהבטיח את הדומיננטיות של ארה"ב במירוץ הטכנולוגי.

הצו החדש מעלה לא מעט שאלות ותהיות בנושאים של ביטחון לאומי ותרבות, אבל לא עוסק דווקא בשאלה עמוקה ודחופה בהרבה עבור המגזר העסקי: מי נושא באחריות כאשר מערכות AI טועות, מטעות ומבלבלות?

הוראותיו של טראמפ, כפי שפורסמו ב-TechCrunch, מכוונות בעיקר למפתחי המודלים ולשימושים ממשלתיים. אך מה לגבי מיליוני הארגונים ברחבי העולם שכבר משתמשים ב-AI מדי יום? המציאות היא ש"כולם כבר משתמשים בזה", וההתפוצצות של כלי AI גנרטיביים בשנתיים האחרונות הפכה את הדיון התיאורטי למציאות עסקית דוחקת. ללא מסגרת רגולטורית ברורה, ארגונים צועדים בעיניים פקוחות לתוך שדה מוקשים משפטי.

ניקח לדוגמה סוגיה פשוטה לכאורה: יצירת תוכן. חברת שיווק משתמשת במחולל תמונות כדי ליצור קמפיין מרהיב ללקוח. התמונות ייחודיות, הקמפיין מצליח, והכל נראה נפלא. אבל מה יקרה בעוד שלוש שנים, כאשר אמן יטען שהמודל שייצר את התמונות "למד" מיצירותיו המוגנות בזכויות יוצרים וייתבע את חברת השיווק על הפרתן? תרחיש זה לא היפותטי; תביעות ענק כבר מתנהלות כיום נגד מפתחות מודלי השפה והתמונה הגדולות בעולם בדיוק בגין טענות כאלו. האם האחריות היא על מפתחת המודל, על החברה שהשתמשה בו או על הלקוח שפרסם את התוצר? המרחב האפור הזה, שבו הגבולות בין יצירה, בעלות ושימוש מיטשטשים, הוא מתכון לאסון משפטי ויכול לגרור ארגונים להוצאות לא צפויות.

כל עדכוני ה-IT, תשתית וטכנולוגיה בערוץ הטלגרם של ITtime

חדשנות שהפכה לתביעה

הבעיה מחריפה אף יותר כאשר אנו עוברים מתמונות לבני אדם. ארגונים מסתמכים יותר ויותר על כלי AI כדי להחליט מי יקודם, מי יפוטר ואפילו את מי לגייס. כלים אלו מבטיחים אובייקטיביות ויעילות, אך המציאות מורכבת. מחקרים חוזרים ומראים כיצד מודלי AI משמרים ואף מעצימים הטיות מגדריות קיימות גם בשאלת הקבלה לעבודה וגם בנושאי שכר. דמיינו כלי שסורק קורות חיים ומסנן אוטומטית מועמדים שלקחו הפסקה ארוכה מהעבודה – החלטה שעלולה לפסול באופן שיטתי אימהות טריות. הנזק כאן הוא לא רק משפטי, אלא גם תדמיתי ומוסרי.

כאשר עובד או מועמד לעבודה יטען לאפליה, על מי מוטלת חובת ההוכחה? האם הארגון יוכל להסתתר מאחורי ה"קופסה השחורה" של האלגוריתם? סביר להניח שלא. הרגולטורים והמשפטנים לא יקבלו את התשובה "המחשב החליט" לאורך זמן.

וכאן אנו חוזרים לצו של טראמפ שמדגיש נקודה קריטית: ממשלות מתחילות להסדיר את התחום. אך בעוד ארה"ב מתמקדת בהיבטים אידיאולוגיים ותחרותיים, באיחוד האירופי, למשל, מקדמים את "חוק הבינה המלאכותית" (EU AI Act) – ניסיון לייצר רגולציה מקיפה המבוססת על רמות סיכון. הגישות השונות הללו יוצרות פסיפס רגולטורי מורכב, שמקשה על חברות גלובליות לפעול.

לכן, השוק הפרטי לא יכול לחכות. ארגונים חייבים להבין שהשימוש בכלי AI מטיל עליהם אחריות כבדה. עליהם לעבור מניהול סיכונים פסיבי לאסטרטגיה פרואקטיבית: לדרוש שקיפות מספקיות הטכנולוגיה, להקים ועדות אתיקה פנימיות שיבחנו כלים חדשים, לקבוע מדיניות ברורה של "אדם בתוך הלולאה" (Human-in-the-loop) עבור החלטות קריטיות, ולבצע ביקורות מחמירות על ההטיות של המערכות.

העידן שבו ניתן היה להתייחס ל-AI ככלי ניסיוני הסתיים. היום, הוא חלק אינטגרלי מהפעילות העסקית. ללא רגולציה ממשלתית ברורה והכרה באחריות התאגידית, ארגונים עלולים לגלות שהחדשנות שאימצו אתמול היא לא רק תביעת המיליונים של מחר, אלא הפצצה המתקתקת שמאיימת על המוניטין והיציבות שלהם.