הפרדוקס של ה-AI: הוא יודע הכל וזו בדיוק הבעיה

כשהפיתוח מואץ, האמון הופך למטבע היקר ביותר, ובתעשייה חייבים להבין: שקיפות ושליטה הם הפיצ'רים החדשים

נוצר באמצעות AI

אנחנו בעידן של Vibe coding ובו כבר אין צורך בצוות גדול או תקציב עתק כדי להוציא מוצר עובד ביממה אחת בלבד – מספיקים רעיון, מודל שפה ותשתיות בסיסיות. הדמוקרטיזציה הזו מלהיבה ומסעירה, אך היא גם הופכת את האמון שלנו במוצר ובטכנולוגיה למשאב הנדיר והיקר ביותר – ככל שקל יותר לבנות מוצר, כך קל יותר לאבד את אמון המשתמשים בו. למה? משום שמערכות AI עונות בביטחון מלא גם כשהן טועות ומייצרות אשליה מסוכנת של ודאות, וכשהמשתמשים מזהים את הטעות הם מאבדים את תחושת הביטחון.

אבל זה לא המקרה היחיד שיכול לפגוע באמון המשתמשים, גם מקרים של חוסר שקיפות לגבי מדיניות האבטחה או אימון המודלים, הטיות או חשש ליצירת תכנים המוגדרים כדיפ פייק, יכולים להרתיע. וזו בדיוק הסיבה שבגללה חשוב לשלב את סוגיית האמון כחלק מהותי מהארכיטקטורה של המוצר ושל חוויית המשתמש, משום שאחרת כלי ה-AI יישארו בגדר גימיק נוצץ במקום להפוך למערכות שאפשר להפקיד בידיהן החלטות הרות גורל.

לא חסרות דוגמאות לסדקים האלה רק מהשנה החולפת. משתמשים דיווחו כי Google AI Overviews ענתה בביטחון ובשפה חד משמעית לשאלה הפשוטה: "האם עכשיו שנת 2025?" שאנחנו עדיין ב-2024. התיקון הגיע במהירות, אך הסדק נפער: אם המנוע לא מצליח לזהות את השנה הנוכחית, מדוע שנפקיד בידיו מידע רגיש בתחומים כמו בריאות או פיננסים? וכאן גם נחשף הפרדוקס כולו: תשובות מוחלטות אולי משדרות סמכותיות, אך גם מייצרות אובדן אמון.

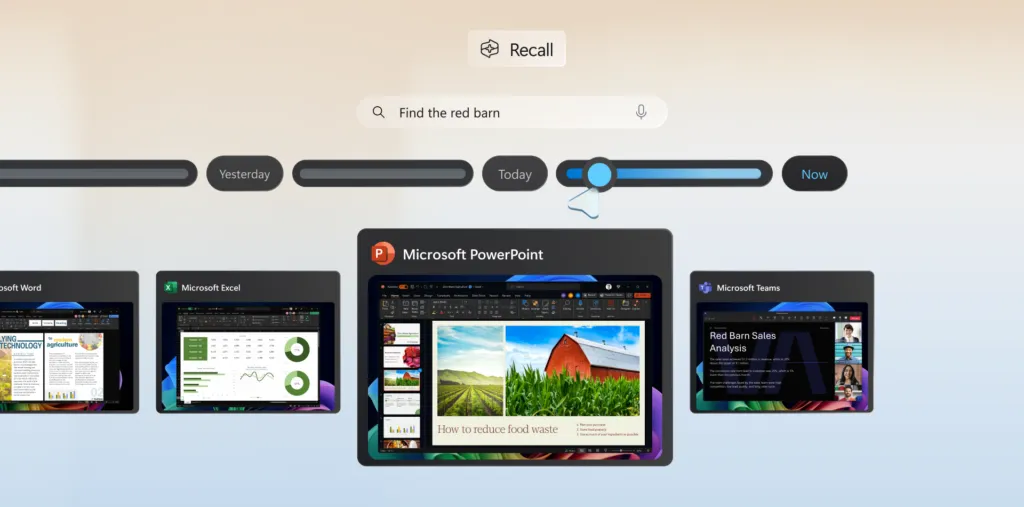

גם מיקרוסופט חוותה סערה סביב הפיצ'ר Recall שנועד לצלם מסך באופן רציף כדי לספק "זיכרון" חכם. המוצר הושק מחדש כמעט שנה לאחר שהוצג, הפעם עם הצפנה, דרישת זיהוי ביומטרי ואפשרות הצטרפות בלבד. למרות השיפורים, הרעיון שמערכת מתעדת היסטוריה ויזואלית של כל פעילות המשתמש עורר אי נחת ציבורית. גם אם הנתונים נשמרים מקומית, הסיכון מחדירה למחשב או מהיעדר מדיניות ארגונית ברורה הוא מטריד. הלקח ברור: שקיפות מלאה, ברירות מחדל שמרניות והזכות להישכח אינם תוספות מוצריות, אלא תנאי בסיסי לאמון.

מיקרוסופט Recall. תמונה: מיקרוסופט

ויש עוד צד לפגיעה באמון: החשש מההשפעות ההרסניות של הטכנולוגיה. בחודש יולי האחרון הזהירה ממשלת אנדרה פרדש שבהודו מפני סרטון מזויף שבו נראה ראש הממשלה מאיים כביכול על חקלאים. זהו אינו עוד קליפ משעשע אלא דוגמה למנגנון שמערער אמון ציבורי בזמן אמת. במקביל, דוח של ITU התריע כי בחירות וכלכלה כבר מושפעות עמוקות מדיפ פייק, נציבות זכויות האדם של האו״ם הזהירה כי הטכנולוגיה מאיימת על תהליכים דמוקרטיים ובארצות הברית ה-FBI והמערכת הפיננסית הפיצו חומרים חינוכיים לציבור על זיהוי הונאות קול ותמונה. כאשר אפליקציה חינמית מסוגלת לייצר חיקוי קול או וידאו בתוך דקות ספורות, תחושת הבטן כבר אינה כלי הגנה.

למה המודלים ממציאים בכלל?

במאמר של OpenAI מוסבר כי הזיות (hallucinations) אינן תקלה מצערת, אלא תוצר ישיר של התמריצים שמקבלים המודלים. רוב ההערכות היום מתגמלות תשובות נכונות, אך אינן נותנות קרדיט על הודאה באי ודאות. בדיוק כמו תלמיד במבחן אמריקאי שמעדיף לנחש ולא להשאיר ריק, כך גם המודל לומד שעדיף לחרטט בביטחון מאשר להודות שאינו יודע.

משתמשים יודעים ומבינים שרמת הדיוק לעולם לא תגיע ל-100%, אבל יש גם שאלות שאי אפשר לקבוע להן תשובה חד משמעית ושגיאות בטוחות שפוגעות עמוק באמון. במחקר של OpenAI מודגש כי הדרך לשנות זאת היא לעדכן את אופן ההערכה: להעניש שגיאות בטוחות יותר מאשר אי מענה, ולתגמל הצגת אי ודאות או בקשת הבהרה. זה לא רק שינוי טכני אלא מהפכה מחשבתית ממודל שנמדד על "תשובה נכונה" למערכת שנמדדת על אמינות, שקיפות ויכולת להודות במגבלותיה.

בדיוק כמו תלמיד במבחן אמריקאי שמעדיף לנחש ולא להשאיר ריק, כך גם המודל לומד שעדיף לחרטט בביטחון מאשר להודות שאינו יודע

היישום של הגישה הזו נמצא בעיקר בידי מפתחי המודלים הגדולים, אך גם ארגונים שבונים מודלים פרטיים יכולים לאמץ אותה: להגדיר סף ביטחון שמעליו מוצגת הסתייגות, להוסיף שכבת UX שמתרגמת את רמת הביטחון לשפה ויזואלית או טקסטואלית בהירה, ולעודד משתמשים לשאול לגבי רמת הוודאות בתשובות ובכך לעודד תרבות של מחשבה ביקורתית, הכרה במגבלות, כנות ושקיפות.

ארכיטקטורה של יחסים

דוח Stanford AI Index 2025 מצביע על עלייה של יותר מ-50% במספר התקריות המדווחות, מ-149 ב-2023 ל-233 ב-2024. הוא גם מדגיש את הפער בין ההכרה בסיכונים ובין היכולת לייצר מנגנוני הערכה וסטנדרטים אחידים. המשמעות ברורה: הצהרות על אחריות במוצר אינן מספיקות, יש להראות כיצד היא מתבטאת בממשק, בדוקומנטציה ובתהליכי העבודה.

היום כבר נכנסים לשימוש תהליכי Agentic UX. במקום ממשקים שמחכים לקליקים, נבנים סוכנים שפועלים באופן יזום בשם המשתמש – הם מזהים הקשר, מציעים מהלך ואף מבצעים אותו כשהדבר בטוח. כדי שסוכן כזה יהיה ראוי לאמון, עליו לעבוד על פי חוזה פסיכולוגי ברור: מה מותר לו לעשות לבד, היכן עליו לבקש אישור, כיצד הוא מתעד פעולות ואיך אפשר לעצור אותו בכל רגע. כך המשתמש אינו מפעיל מכונה, אלא מנהל שותפות.

כל עדכוני ה-IT, תשתית וטכנולוגיה בערוץ הטלגרם של ITtime

חשוב להגיד שבכך לא נפתרות כל הבעיות, עולות כאן שאלות אתיות עמוקות. למי נאמן הסוכן – לארגון, למשתמש או לאינטרס מסחרי או פוליטי אחר? האם הוא שקוף לגבי מקורות המידע והשפעתם? מהי מידת האוטונומיה הראויה בהקשרים קריטיים כמו בריאות, אשראי או תעסוקה? האם מותר לאמן מודל על דאטה ציבורי שנוצר על ידי אנשים שלא הבינו שייעשה בו שימוש כזה? מי נושא באחריות כאשר סוכן טועה בשם המשתמש ומתי נכון להשתמש בפתרון מקומי כדי לצמצם סיכוני זליגה לעומת יעילות אימון בענן?

אמון אינו תוצאה של קוד טוב בלבד, הוא תוצר של תחושות אנושיות בסיסיות: שליטה, ביטחון, שקיפות והוגנות. כדי להפוך את ההבנה הזו לפרקטיקה, עלינו לאמץ עקרונות מוכרים מהפסיכולוגיה של הבניית אמון: תיאום ציפיות באמצעות הצגת אי ודאות, מתן תחושת שליטה דרך אפשרות חרטה ו-Undo בכל שלב, סבילות לשגיאות והיכולת להתאושש מהן במהירות, עיצוב חוויות שמקטינות את הסיכון הנתפס, יצירת מנגנוני הוגנות ברורים ותיעוד שקוף וזמין לכל.

כדי לזכות באמון, אנשי הטכנולוגיה לא יכולים לחשוב יותר רק במונחים דיכוטומיים של תשובות נכונות ושגויות, אלא לעבור לחשיבה על צרכים אנושיים – המשתמשים אינם מחפשים שלמות אלגוריתמית, אלא מענה לצרכים ותשובות לרצונותיהם בצורה הוגנת ושקופה. הפתרון לא טמון בשאיפה לדיוק מוחלט, אלא ביכולת להודות באי ודאות ולתעדף שקיפות על פני ניחוש בטוח.

מירית דקטור היא סמנכ"לית UX & Product Design בחברת BigID, המחברת בין דאטה לבין בינה מלאכותית